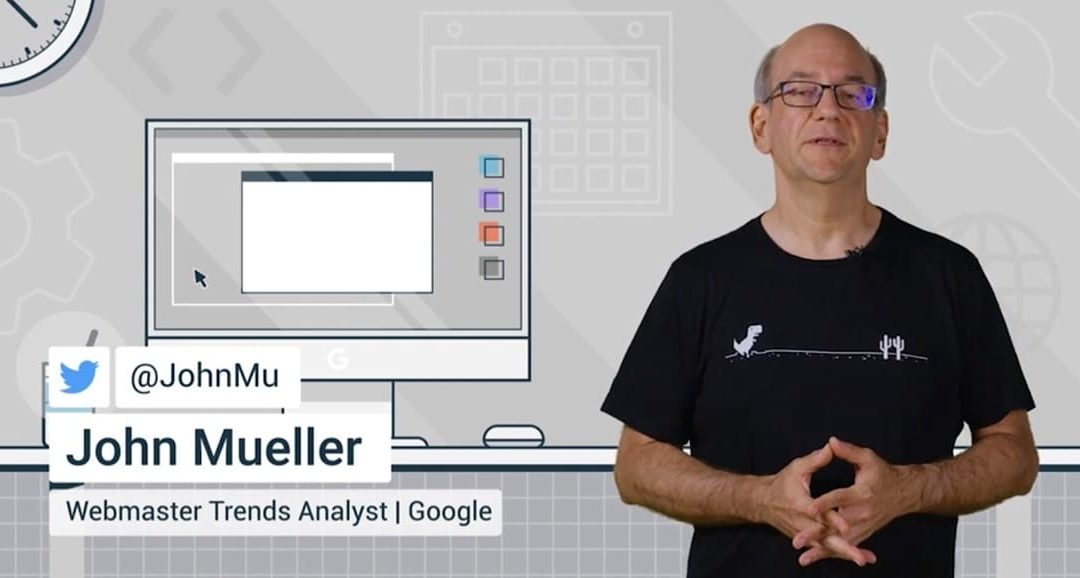

El mensaje de “Page indexed without content” en Search Console se ha convertido en un pequeño quebradero de cabeza para muchos SEOs y responsables de web, y ahora una explicación de John Mueller, portavoz de Google Search, ayuda a entender mejor qué hay detrás de este aviso, según recoge la fuente original. De acuerdo con la información publicada, el problema suele estar más relacionado con bloqueos a nivel de servidor o CDN que con fallos de JavaScript, algo que rompe con la idea que muchos profesionales tenían sobre este tipo de errores.

John Mueller apunta al servidor y al CDN como origen del problema

Según la fuente, John Mueller respondió en Reddit a un usuario que había visto cómo su homepage pasaba de la posición 1 a la 15 tras aparecer el error “Page indexed without content” en Search Console. En ese intercambio, Mueller explicó que lo habitual es que el servidor o el CDN estén bloqueando a Google para que no pueda recibir ningún contenido, y remarcó que no se trata de un problema vinculado directamente a JavaScript.

De acuerdo con las palabras citadas por la fuente, Mueller detalla que este bloqueo suele darse en un nivel bastante bajo, a veces basándose en la dirección IP de Googlebot, lo que hace que sea prácticamente imposible de detectar con herramientas externas. Por eso, el experto de Google señala que las pruebas habituales que realizan los SEOs, como peticiones manuales o revisiones externas, pueden devolver resultados normales mientras Googlebot sigue encontrándose con páginas “vacías” o sin contenido útil.

En el caso que se describe en la nota, el propietario del sitio ya había probado varios diagnósticos avanzados y no encontraba nada raro a primera vista. Según los datos facilitados, el usuario lanzó comandos curl simulando a Googlebot, revisó posibles bloqueos relacionados con JavaScript y utilizó la prueba de resultados enriquecidos de Google para intentar replicar el fallo. Aun así, el comportamiento era inconsistente: las herramientas de inspección en escritorio devolvían un mensaje genérico de “Something went wrong”, mientras que las de móvil parecían funcionar con normalidad.

La fuente subraya que, para Mueller, todo esto encaja con un tipo de bloqueo que no se detecta fácilmente desde fuera de los sistemas de Google. El propio portavoz indica que las herramientas externas, incluidos los curl manuales, no siempre reproducen lo que ve Googlebot cuando se topa con reglas específicas a nivel de infraestructura. Por eso insiste en que este tipo de casos deben tratarse con urgencia, porque las páginas afectadas pueden empezar a desaparecer del índice progresivamente sin que el tráfico caiga de golpe de un día para otro.

Un caso real con Webflow y Cloudflare de fondo

Según la información publicada, el sitio afectado por este problema utiliza Webflow como CMS y Cloudflare como CDN, una combinación bastante habitual en proyectos de pequeña y mediana escala. La persona afectada indicó que la página principal se había estado indexando con normalidad y que no había realizado cambios relevantes en el sitio justo antes de que apareciera el error en Search Console, algo que hace aún más desconcertante la situación para quienes la sufren.

La fuente destaca que este tipo de escenario no es nuevo y que ya se han documentado otros casos en los que las configuraciones de CDN o servidor terminan bloqueando de forma inesperada a Googlebot. En muchas ocasiones, estos bloqueos no afectan a los usuarios reales ni a las visitas normales, por lo que el sitio sigue pareciendo accesible para todo el mundo menos para los sistemas de rastreo de Google. Esto genera una sensación de normalidad que puede retrasar la detección del problema por parte de los responsables SEO.

De acuerdo con la crónica del medio, el detalle de Cloudflare llamó especialmente la atención porque existen antecedentes muy similares. En otro caso analizado, Mueller ya había asesorado a un propietario de varios sitios cuyo rastreo se había detenido casi al mismo tiempo en distintos dominios. Todos esos proyectos compartían el uso de Cloudflare, y el portavoz de Google apuntó entonces a la “infraestructura compartida” como posible causa de esos fallos aparentemente simultáneos.

Según recuerda la fuente, también se ha informado de incidentes más amplios relacionados con esta tecnología, como una caída de Cloudflare registrada en noviembre que generó picos de errores 5xx y afectó directamente al rastreo de múltiples sitios. En aquella ocasión se trató de un problema masivo, pero el caso actual parece ser más específico, y se orienta hacia reglas de protección de bots o configuraciones de firewall que podrían estar tratando de manera diferente a las IP de Googlebot frente al resto del tráfico.

Por qué el error “Page indexed without content” es importante

Más allá del caso concreto, la fuente recuerda que Google ya había explicado el significado general del estado “indexed without content” en su documentación de ayuda. Según esos materiales citados, este mensaje indica que, por algún motivo, Google no ha podido leer el contenido de la página, y aclara que no se debe a un bloqueo por robots.txt. La causa, como señalan esos recursos, suele encontrarse en capas más bajas de la pila técnica, como configuraciones de servidor, CDN o filtros de seguridad.

Para responsables de SEO y administradores de sitios, este contexto es relevante porque demuestra que el problema no se soluciona ajustando solo elementos de contenido o etiquetas HTML. De acuerdo con la fuente, cuando aparece “Page indexed without content” hay que pensar en la infraestructura que hay por debajo, especialmente si el sitio usa servicios de terceros como Cloudflare u otros proveedores de proxy inverso. Estas capas pueden aplicar reglas automáticas que bloqueen parcialmente el acceso de Google sin que el propietario sea plenamente consciente.

El artículo citado también recuerda que las herramientas de Search Console, como la Inspección de URL y el test de URL en vivo, siguen siendo la forma más fiable de ver lo que realmente recibe Google al rastrear una página. Según la fuente, cuando estas herramientas devuelven errores mientras otros tests externos funcionan, el escenario más probable es que exista un bloqueo a nivel de servidor o CDN enfocado en ciertas direcciones IP. Esa combinación de señales es la que debería disparar las alarmas en cualquier equipo técnico o de SEO.

En palabras del análisis recogido, este tipo de problemas se han ido repitiendo en los últimos años, especialmente a medida que los sitios se apoyan más en servicios en la nube y soluciones de seguridad automatizada. Para los profesionales de posicionamiento, la lectura es clara: no basta con mirar el código de la página, hay que revisar también las capas de infraestructura y entender qué filtros pueden estar actuando sobre el tráfico de Googlebot.

Recomendaciones para quien vea este error en Search Console

Según los consejos que recoge la fuente, si un sitio empieza a mostrar el error “Page indexed without content”, el primer paso debería ser revisar la configuración del servidor y del CDN en busca de reglas que afecten a las IP de Googlebot. Google publica de forma oficial sus rangos de direcciones, y esa información puede servir para detectar si alguna política de seguridad está bloqueando o limitando de forma agresiva estas peticiones. La prioridad, según el enfoque de Mueller, es tratarlo como un asunto urgente.

La nota señala que, una vez verificado que no se trata de un problema de robots.txt ni de JavaScript, tiene sentido usar intensivamente herramientas como la Inspección de URL en Search Console. De acuerdo con la fuente, estas pruebas muestran de forma directa qué ve Google cuando intenta acceder a la página, algo crucial cuando el bloqueo se basa en la dirección IP y no en el contenido o en los encabezados. En este contexto, las pruebas externas pueden dar una falsa sensación de seguridad.

Para quienes utilizan Cloudflare, la fuente recomienda prestar especial atención a los ajustes de bot management, a las reglas de firewall y a cualquier control de acceso basado en IP. Incluso cuando el propietario no haya tocado nada manualmente, pueden haberse aplicado cambios mediante actualizaciones automáticas o nuevos ajustes por defecto. Esa evolución silenciosa de la configuración puede explicar por qué un sitio que antes se indexaba sin problemas empieza de repente a mostrar errores como “Page indexed without content”.

En última instancia, el mensaje que se desprende de la explicación de Mueller, tal y como la recoge la fuente, es que los errores de indexación a menudo nacen en decisiones técnicas aparentemente menores. Para los gestores de sitios y especialistas en SEO, esto implica revisar de forma periódica los proveedores de infraestructura y entender qué automatismos pueden estar afectando al tráfico de Google. Solo así se puede evitar que una página aparezca como indexada pero sin contenido y termine perdiendo visibilidad en las búsquedas.

Fuente:https://www.searchenginejournal.com/googles-mueller-explains-page-indexed-without-content-error/564575/